Comment mesurer avec fiabilité la visibilité d’une marque ou d’un produit dans les réponses générées par les IA ?

Avec l’arrivée des IA génératives, l’analyse de la visibilité de marque évolue : l’information peut être intégrée directement dans une réponse conversationnelle, qui contient (ou non) des marques, des produits, des sources.

Dans ce contexte, les indicateurs qui structurent l’essentiel des reportings et de la mesure de la performance SEO (suivi des positions, mesure du CTR…) commencent à montrer leurs limites. Comment adapter les méthodes de mesure à cette nouvelle forme de visibilité conversationnelle ?

Fréquence de citation, ordre d’apparition, tonalité, sources… ce travail s’apparente à la construction d’un nouveau champ d’analyse.

De nombreux outils surfent sur ce besoin avec des promesses séduisantes : dashboards IA, scores de visibilité en un clic, monitoring en temps réel.

Derrière l’effet waouh et les tarifs souvent élevés, la réalité est plus complexe. Tous ne se valent pas, les protocoles de collecte sont rarement transparents, les métriques parfois bancales, et les biais méthodologiques fréquents.

La communauté SEO se retrouve face à une offre foisonnante mais difficile à évaluer, et le risque est de payer pour des indicateurs qui n’ont pas de valeur opérationnelle réelle.

L’objectif de cet article est triple :

- Définir ce que signifie “visibilité de marque” dans le contexte des IA

- Proposer une méthode pour la mesurer, centrée sur l’utilité réelle

- Démystifier les fausses promesses marketing en identifiant les limites claires des outils de monitoring

Comprendre le basculement : pourquoi tout le monde cherche à monitorer la visibilité dans les IA ?

Pendant plus de deux décennies, le suivi de visibilité s’est concentré sur les pages de résultats des moteurs de recherche, avec des métriques mesurables et relativement fiables (volumes de recherche, nombre de clics…). Avec les IA génératives, ce cadre est bouleversé. L’utilisateur est confronté à une réponse synthétique qui n’est pas figée et peut varier d’une requête à l’autre.

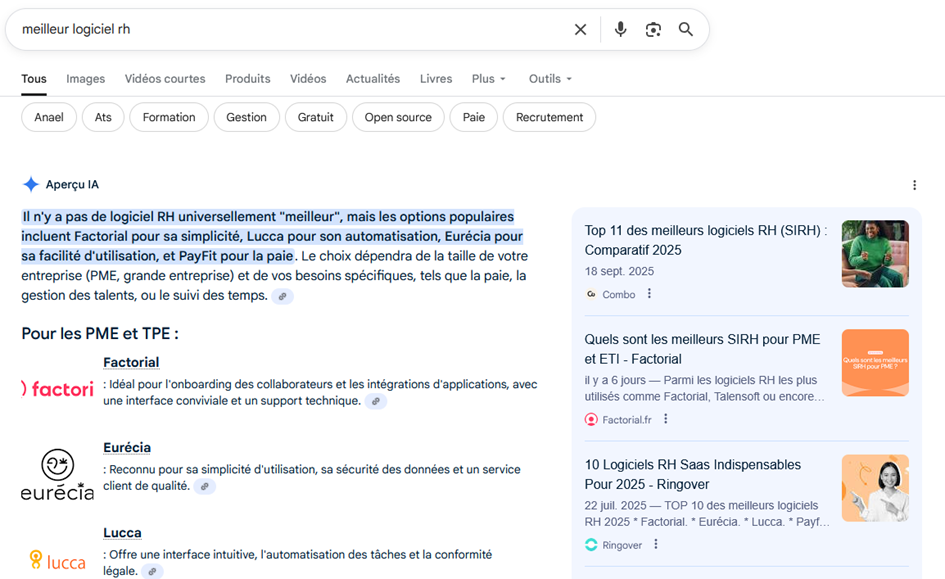

Le LLM agit comme un filtre : parmi l’ensemble des marques, produits et sources disponibles en ligne, il n’en retient que quelques-uns pour construire son discours. La visibilité dépend donc de la capacité d’une marque à être intégrée dans cette nouvelle couche de réponse.

Nous retenons trois dimensions pour comprendre ce basculement qui approche :

- Réduction mécanique du trafic organique : lorsqu’une réponse IA suffit, l’utilisateur clique moins. Plusieurs études montrent déjà une baisse du CTR sur les premières positions quand une AI Overview est présente dans Google (ce qui n’est qu’une question de temps en France).

- Nouvelle hiérarchie de visibilité : c’est la mention dans le texte généré qui compte. Une marque citée en premier, ou associée à une recommandation explicite, capte l’attention. Être simplement mentionné en source n’est plus suffisant.

- Multiplication des points d’exposition : au-delà de Google, d’autres plateformes conversationnelles s’imposent (ChatGPT, Perplexity, Gemini). Chacune a ses propres règles de citation, ses biais, et sa manière de mettre en avant une marque.

Ces évolutions imposent de considérer la visibilité comme une présence dans une narration générée par IA. Le monitoring devient alors le seul moyen de comprendre si une marque existe ou non dans ce nouvel écosystème informationnel.

Problème : sans équivalent d’un outil centralisé comme Google Search Console, il est aujourd’hui impossible de monitorer cette visibilité de façon simple et fiable. La communauté SEO s’active pour répondre à ce besoin.

La théorie : comment évaluer avec pertinence la visibilité de marque dans les IA ?

Dans le search classique, la visibilité se mesure avec des indicateurs qui reposent sur un affichage stable : une SERP composée de liens. Avec les IA génératives, tout change. La visibilité est une question de présence dans une réponse produite par un modèle, et la construction de cette réponse suit un process très différent.

Pour bâtir un suivi pertinent, il devient nécessaire de comprendre et de définir ce que l’on observe.

La réponse IA : une unité d’analyse floue

La réponse produite par une IA est l’objet central du monitoring que l’on souhaite mettre en place. Chaque réponse contient ou non une marque ou un produit, elle s’appuie ou non sur des sources, et elle est formulée dans un certain ton. C’est sur cet objet complexe que repose toute la mesure.

Problème : cette réponse change à chaque fois. Deux sessions différentes, une variation de contexte, de formulation, ou un changement d’IA donnent des résultats différents. La mesure de la visibilité devient plus abstraite que jamais. Dans ce contexte, comment construire un monitoring pertinent, qui reflète la réalité vécue par un utilisateur ciblé ?

Dans le search, les volumes de recherche offrent une base chiffrée pour analyser la demande. Avec les IA, cette donnée n’existe pas. On ne sait pas combien de fois une question est posée ni combien d’utilisateurs voient une marque citée.

Conséquence : le score n’est jamais absolu, il est forcément relatif.

L’analyse de visibilité ne vaut que dans une logique comparative, entre concurrents et sur un corpus donné.

Le persona comme clé de lecture

Les réponses d’une IA ne sont pas universelles. Elles varient selon la manière dont la question est posée et le profil implicite de l’utilisateur. Un monitoring qui ne tient pas compte du persona mesure une visibilité sans rapport avec la cible réelle de la marque.

L’intention de recherche comme cœur d’analyse

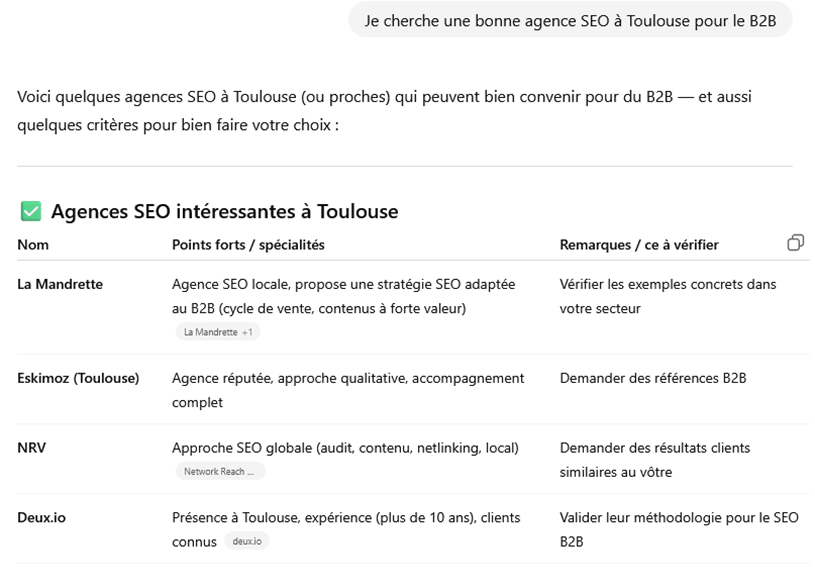

Toutes les questions ne déclenchent pas la citation d’une marque. Les IA génératives fonctionnent par construction de réponse : si la question est purement descriptive ou théorique, le modèle n’a pas de raison d’introduire des acteurs du marché. À l’inverse, lorsqu’une demande touche à la comparaison, au choix ou à l’achat, la probabilité de voir apparaître des marques augmente fortement.

Segmenter les questions par intention de recherche devient un axe de travail. Cela permet de comprendre où une marque est spontanément citée, et sur quels terrains elle est absente.

Comme pour le SEO traditionnel, il est tentant de distinguer trois grandes familles :

- Intention informationnelle : l’utilisateur cherche à comprendre un problème ou un concept. Les marques sont rarement citées.

- Intention comparative : l’utilisateur veut confronter plusieurs solutions. C’est le terrain naturel de l’évocation de marques concurrentes.

- Intention transactionnelle : l’utilisateur cherche un produit, une application ou un dispositif concret. Les marques / produits apparaissent presque toujours.

Ce signal est précieux à analyser : il révèle si une marque est perçue comme une référence pédagogique ou comme une option finale d’achat.

Mais l’intention ne suffit pas à expliquer les variations de visibilité. La manière dont la question est formulée joue un rôle tout aussi déterminant. Deux prompts exprimant la même intention peuvent produire des résultats très différents : l’un incitera l’IA à citer des marques, l’autre restera générique.

Cette dimension évolutive amène de nouvelles problématiques pour le monitoring :

- Comment viser juste quand tous les prompts sont uniques ?

- Faut-il mesurer la réalité actuelle et privilégier des formulations proches de celles que les utilisateurs emploient réellement ?

- Faut-il explorer des formulations alternatives, tester des variantes qui pourraient encourager l’IA à citer des acteurs, pour identifier quelles marques émergent dans ce cadre ?

- Faut-il anticiper les évolutions des modèles ?

Un monitoring différent pour chaque plateforme ?

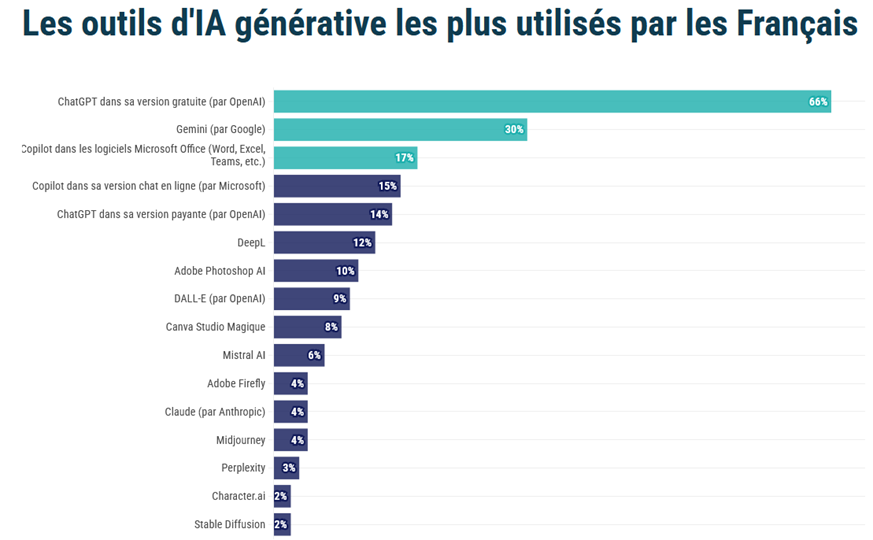

La visibilité d’une marque ne se mesure pas de la même façon selon la plateforme utilisée. Chaque IA a ses propres règles de génération, son rapport aux sources et sa manière de citer les marques. L’étude Ipsos réalisée en février 2025 mettait déjà en valeur la grande diversité des plateformes utilisées par les Français.

Certaines IA comme Gemini privilégient des réponses très détaillées mais peu sourcées, d’autres comme Perplexity multiplient les citations de domaines. Les modes d’affichage diffèrent également : liens cliquables, encadrés, recommandations implicites… autant de facteurs qui influencent la manière dont une marque est perçue par l’utilisateur final.

Quelles plateformes suivre dans le cadre d’un monitoring IA ?

- ChatGPT Gratuit : sans sources, mais révélateur de la “culture de base” intégrée dans le modèle, utile pour voir quelles marques sont installées dans le “fond de mémoire”.

- ChatGPT Payant : réponses souvent sourcées, adapté pour mesurer la présence dans un environnement “augmenté”, représentation théorique d’un usage futur des IA dans le contexte de la recherche web.

- Perplexity : citations cliquables et systématiques, particulièrement utile pour analyser les domaines qui nourrissent les mentions de marque.

- Gemini : IA incontournable à la logique plus opaque, avec des citations variables et parfois non cliquables, ce qui rend le suivi plus instable et difficile à interpréter.

- Microsoft Copilot : adossé à Bing, il combine génération et résultats de recherche. Ses réponses mettent en avant à la fois des formulations synthétiques et des sources ancrées, ce qui en fait un environnement hybride intéressant à suivre.

- Google AI Overviews : intégré directement dans la SERP, ce système captera prochainement une part massive de l’attention utilisateur. Les marques citées dans ces résumés bénéficient d’une visibilité forte, mais la fonctionnalité n’est pas encore déployée en France, ce qui limite aujourd’hui le monitoring local…

…la liste des IA peut être longue, et des arbitrages sont forcément nécessaires pour sélectionner les plateformes en fonction des objectifs du projet.

En segmentant les résultats par LLM, on obtient un panorama nuancé : une marque peut dominer dans Perplexity, disparaître dans Gemini et rester stable dans ChatGPT. Cette diversité rend l’analyse riche et exploitable, à condition de garder en tête les biais propres à chaque environnement.

Des indicateurs de visibilité utiles et analysables

Une fois les bases posées, la question devient : qu’est-ce qu’on mesure exactement ?

- Taux de présence

- Part de visibilité par IA

- Comparatif concurrents

- Fiabilité des sources associées

- Contexte d’association

- Stabilité dans le temps

- …

Ici aussi, les possibilités sont nombreuses, et toutes les métriques accessibles ne sont pas forcément pertinentes pour répondre à des objectifs concrets, comme :

- savoir si une marque existe dans le paysage généré par les modèles,

- mesurer son poids face aux concurrents,

- comprendre sur quelles sources et dans quels contextes elle est associée,

- identifier des opportunités d’action (renforcer la présence sur les domaines mentionnés, créer du contenu mieux aligné avec les questions qui déclenchent des citations, corriger les biais constatés)

Tous ces indicateurs constituent une base solide, mais ils ne suffisent pas à eux seuls. Les possibilités d’analyse sont nombreuses, et il serait réducteur de s’arrêter à une lecture purement quantitative.

La valeur réelle du monitoring se joue dans l’interprétation qualitative : pourquoi une marque est-elle citée dans tel contexte, pourquoi est-elle associée à certains concurrents et pas à d’autres, quelles formulations l’IA utilise pour la décrire ?

Ce travail d’analyse ne peut pas être automatisé intégralement. Il exige l’œil d’un expert capable de relier la donnée aux enjeux de marché, et de transformer ces signaux en recommandations concrètes.

Liste des outils de monitoring de visibilité IA existants

La liste des nouveaux outils est déjà longue :

- Profound

- Peec AI

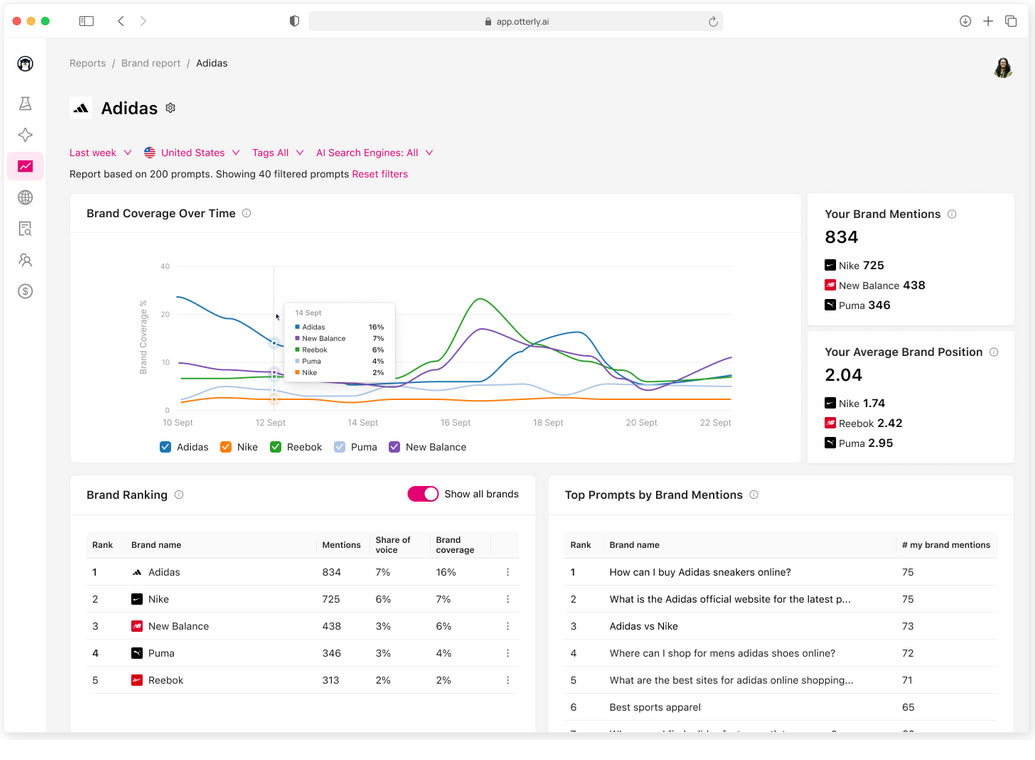

- Otterly.ai

- Trakkr.ai

- Am I On AI?

- Rankscale

- LLMrefs

- Knowatoa

- Scrunch AI

- Gumshoe AI

- Passionfruit Labs

- …

Les plateformes SEO historiques s’adaptent aussi à l’IA :

- Ahrefs (Brand Radar) : suivi de la visibilité IA multi-prompts/plateformes

- Semrush : Tracking des AI Overviews

- Sistrix : Filtre AIO (présence/citation) et analyses dédiées par mot-clé.

- Similarweb : Rank Tracker avec détection des mots-clés qui déclenchent des AI Overviews

Que penser de tous ces nouveaux outils ?

Ils tentent avec plus ou moins de succès de rendre mesurable un phénomène complexe. Tableaux, courbes, parts de voix… de quoi rassurer en un coup d’œil un client ou un directeur marketing. Certains vont plus loin et donnent même des pistes concrètes pour renforcer la présence éditoriale.

Mais leur usage appelle des précautions. Les protocoles ne sont pas toujours transparents : on ignore souvent comment les prompts sont posés, dans quel contexte ou dans quelle langue. Les scores globaux séduisent visuellement, mais mélangent des environnements parfois très différents.

L’analyse quantitative prime souvent face à l’analyse qualitative.

Retour d’expérience : l’exemple d’un bon élève avec Peec AI

Peec AI est un outil plutôt bien pensé : possibilité de suivre jusqu’à cent prompts avec un tarif relativement abordable, historique complet exportable, classement des domaines et des URL les plus cités, suivi des entités concurrentes configurable avec regex, système de tags pour organiser les résultats…

Élément clé : il met à disposition une matière brute très riche et exploitable. Avec cette ouverture, il se démarque clairement d’outils plus “gadgets” qui se contentent d’afficher un score de visibilité sans détails et sans réelle volonté de bien faire.

Mais là encore, il y a des limites :

- Manque de maîtrise du process de prompting (une surcouche semble être ajoutée systématiquement, mais l’outil n’est pas complètement transparent à ce niveau)

- Peec AI exécute, mais c’est à vous de définir une stratégie solide en amont : quels personas, quelles intentions, quelles IA suivre…

- Peu de flexibilité sur les modèles LLM intégrés dans les plans

- …et surtout, la nécessité d’ajouter une couche d’analyse humaine pour transformer la donnée en insights actionnables (qualité des sources, contexte d’association, erreurs éventuelles, tendances stratégiques)

C’est toute l’ambivalence actuelle : entre des solutions “scammy” aux dashboards clinquants mais vides, et des outils sérieux comme Peec AI qui posent de vraies bases mais ne suffisent pas encore à eux seuls, il faut garder une vigilance critique. Sans expertise SEO derrière, aucun de ces outils ne peut réellement guider une stratégie.

Aller plus loin : les étapes à maitriser pour construire un monitoring IA sur mesure

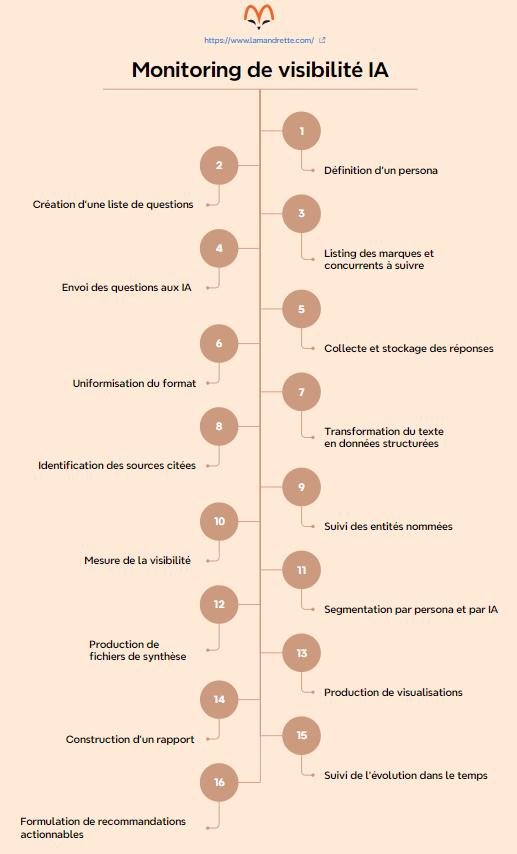

Nous avons commencé par explorer ce terrain de manière assez empirique : tester quelques prompts, observer les réponses, identifier les récurrences… puis, partant du constat qu’aucun outil du marché ne répond complètement aux besoins de nos clients, nous avons conçu notre propre process de monitoring.

Cette démarche s’est structurée autour de différentes observations de terrain. L’objectif étant de disposer d’un cadre clair, reproductible et actionnable pour nos clients, prenant en compte tous les points dont la maitrise nous semble indispensable.

Il n’est d’ailleurs pas exclu que certains outils existants puissent s’emboiter dans ce process pour en prendre en charge certaines phases.

Ce sont les grandes lignes de cette structure artisanale que nous vous partageons ci-dessous :

Étape 1 – Définition d’un persona cible

Le persona permet de décrire le niveau de connaissance, le vocabulaire et les critères de choix de l’utilisateur type. C’est ce travail qui garantit que les questions posées aux IA reflètent la réalité de l’audience. Ce persona est défini en collaboration avec le client.

Étape 2 – Création d’une liste de questions

À partir du persona, on génère une batterie de questions représentatives, couvrant les intentions de recherche qui nous intéressent : informationnelles, comparatives, décisionnelles…

Étape 3 – Listing des marques et concurrents à suivre

Ce référentiel évolutif sert de base pour détecter les mentions dans les réponses IA, et tend à couvrir les différentes mentions qui nous intéressent.

Étape 4 – Envoi des questions aux IA

Les prompts sont envoyés dans différents environnements (ChatGPT, Perplexity, Gemini…). On confronte chaque IA qui nous intéresse aux mêmes questions, pour observer les différences de citation et de sources.

Étape 5 – Collecte et stockage des réponses

Chaque réponse est copiée et sauvegardée dans un format homogène (Word, Excel ou base dédiée). On constitue ainsi un corpus brut qui servira de matière première à l’analyse.

Étape 6 – Uniformisation du format

Pour éviter les biais, toutes les réponses des différents LLM sont mises au même format pour simplifier les traitements ultérieurs. Des arbitrages sont effectués sur les éléments à conserver ou non.

Étape 7 – Transformation du texte en données

Les réponses textuelles sont converties en données structurées (CSV, JSON) pour servir de base à l’analyse quantitative.

Étape 8 – Identification des sources citées

Les domaines et URL mentionnés sont identifiés et comptés. Cela permet de voir quels sites nourrissent réellement les modèles, et sur quels écosystèmes une marque s’appuie (ou non).

Étape 9 – Suivi des entités nommées

Marques, concurrents, produits : tout est recensé et comptabilisé. On obtient une cartographie précise des acteurs présents dans les réponses.

Étape 10 – Mesure de la visibilité

On calcule plusieurs signaux : fréquence des mentions, indice de visibilité, ordre d’apparition, part relative par rapport aux concurrents…

Étape 11 – Segmentation par persona et par IA

On segmente les résultats : visibilité par cible, par intention de recherche, par plateforme. Cette granularité est essentielle pour interpréter correctement les données.

Étape 12 – Production de fichiers de synthèse

Les résultats sont regroupés dans des fichiers Excel clairs (scores de visibilité, sources, entités). Ce sont les livrables concrets à partager.

Étape 13 – Production de visualisations

Graphiques, classements, tableaux comparatifs : l’objectif est de rendre lisible une matière qui peut vite être dense pour le client.

Étape 14 – Construction d’une présentation

Les insights clés sont mis en forme dans un PDF livrable. Ce support illustre les grandes tendances et sert de base aux échanges stratégiques.

Étape 15 – Suivi de l’évolution dans le temps

Un monitoring n’a de valeur que s’il est répété. En comparant mois après mois, on repère les variations, les progressions et les reculs.

Étape 16 – Formulation de recommandations actionnables

Dernière étape, mais la plus importante : traduire la donnée en décisions. Faut-il renforcer la présence éditoriale sur certains domaines ? Ajuster le contenu pour coller aux questions qui déclenchent des citations ? Surveiller un concurrent qui prend soudain de la place ? C’est ce travail d’analyse qui apporte de la valeur ajoutée, et il est unique pour chaque projet.

Retrouvez le process complet au format PDF :

Le score de visibilité parfait existe-t-il ?

Pour suivre la visibilité d’une marque dans les IA, tous les outils cherchent à proposer un indicateur qui combine plusieurs dimensions pour refléter la réalité perçue par l’utilisateur. C’est tout l’enjeu du score de visibilité.

Comment construire un score pertinent ?

Le score de visibilité que nous avons conçu inclut les deux dimensions suivantes :

- Taux de présence : une marque citée dans 50 % des réponses a mécaniquement plus de poids qu’une autre citée dans 5 %.

- Prépondérance dans les réponses : toutes les citations ne se valent pas. Une mention en première position ou dans un rôle central (ex. recommandation explicite) compte plus qu’une apparition perdue en bas de paragraphe. Le score doit donc prendre en compte la position et la prévalence des mentions dans les réponses. C’est sur cette problématique que certains outils se cassent les dents.

Un score de visibilité bien construit est un excellent outil de synthèse. Mais il ne doit jamais être pris isolément.

Ce qui compte, ce n’est pas seulement d’être “numéro 1” sur un graphique, c’est de savoir pourquoi. Il faut apprendre à regarder derrière les chiffres : quelles questions déclenchent la citation, quelles sources sont mobilisées, quelles formulations l’IA utilise.

Sans cette interprétation, le risque est de piloter sa stratégie sur un indicateur séduisant mais trompeur.

Comment juger la qualité d’un outil de monitoring IA ?

Ces nouveaux outils apportent-ils de la valeur réelle ou font-ils juste joli sur un dashboard ?

Sans recul suffisant, chaque plateforme doit être évaluée avec exigence :

- Le process est-il transparent ? L’outil explique-t-il clairement sa méthodologie ?

- Le monitoring est-il flexible personnalisable ? Peut-on adapter le process aux besoins réels (personas, intentions de recherche, LLM), ou l’outil impose-t-il une approche standardisée ?

- Les résultats sont-ils exploitables ? L’outil permet-il de dégager des tendances lisibles ?

- La donnée brute est-elle accessible ? Est-il possible de consulter et d’exporter les réponses complètes, les citations et les sources ?

En pratique, le « bon » outil est surtout celui qui s’intègre dans une stratégie globale et laisse de la place à l’analyse humaine, au lieu de chercher à la remplacer. C’est la ligne de conduite adoptée par tous les acteurs sérieux du marché.

Notre positionnement : vigilance, méthode et valeur ajoutée humaine

Pas de solution miracle

Le monitoring de la visibilité dans les IA est un chantier incontournable, mais encore largement expérimental.

Les outils de monitoring IA ne sont pas inutiles, loin de là. Le problème n’est pas l’existence de ces solutions, mais la tentation de croire qu’un score ou un dashboard “clé en main” suffit à piloter une stratégie. Sans cadre méthodologique clair, on risque de prendre des décisions sur des indicateurs séduisants mais trompeurs.

Les retours d’expérience de la communauté SEO sont indispensables pour différencier les vraies innovations des fausses promesses.

Une méthodologie pour répondre à des besoins identifiés

Tout l’enjeu est de savoir ce que l’on veut observer et pourquoi.

Un bon monitoring repose sur un process maitrisé à tous les niveaux. Les outils sont des briques à intégrer dans un système plus large : c’est la surcouche d’analyse qui donne de la cohérence et de la valeur opérationnelle.

L’expertise pour faire la différence

Notre rôle d’agence est précisément de transformer ces signaux en décisions stratégiques, en reliant les résultats à des actions concrètes (optimisation éditoriale, partenariats de visibilité, création de contenus adaptés aux usages IA…).

Chaque projet est l’occasion d’adapter la recette, de tester, confronter et remettre en question nos pratiques.

L’auteur : Titulaire d’un master en communication, Fantin Deliège a occupé plusieurs postes (rédacteur, chargé de projet) avant de devenir consultant à La Mandrette. Depuis 2021, il met en œuvre les actions SEO sur les projets clients.

L’intelligence artificielle transforme notre métier à toute vitesse ! Pour rester informé :

- Visibilité de marque dans les IA : payons-nous pour du vent ?

- Le vide d’expertise, point aveugle des intelligences artificielles

- IA et SEO : le Chain of Thought redéfinit la recherche en ligne

- Menaces et opportunités de l’IA sur le SEO

- Les IA génératives (GPT-4) en agence SEO

- Fantin Deliège évoque l’IA et le SEO

- Rankbrain, le superpouvoir de Google

- Le SEO expliqué par une IA

- GPT-3 et SEO