Avec l’IA générative, une nouvelle manière d’interagir avec l’information émerge : des entités capables de comprendre, d’organiser le savoir et d’en proposer des usages pertinents.

Pendant des décennies, la recherche en ligne a suivi un schéma bien établi : une requête, une page de résultats, des liens sur lesquels l’utilisateur clique. Un système fluide mais perfectible, dominé par Google. Aujourd’hui, ce modèle vacille. L’IA générative impose une nouvelle logique : les agents raisonnent, synthétisent, guident.

Cette mutation redéfinit les règles du SEO : le clic décline, les SERP changent et les contenus peuvent désormais être évalués pour leur utilité dans le cadre d’un raisonnement automatisé. De quoi nourrir les fantasmes des plus alarmistes : le SEO serait-il sur le point de mourir (encore une fois) ?

Au cœur de ce basculement, un concept retient notre attention : le Chain of Thought (ou “chaîne de pensée”), une mécanique de réflexion en étapes qui structure l’interaction entre les modèles d’IA et l’information, et qui pourrait bien devenir centrale dans la recherche web.

Les points essentiels à retenir

- Les moteurs de recherche IA raisonnent : chaque requête est décomposée en sous-questions implicites, qui sont analysées et croisées dans un processus de “Chain of Thought”.

- Les métriques SEO classiques risquent d’être remises en question : CTR en chute, positions volatiles, personnalisation systématique… le suivi basé sur des mots-clés génériques et centré sur des utilisateurs théoriques sans historique de navigation perd en pertinence.

- Le contenu doit être pensé pour les agents : structure claire, informations hiérarchisées, données facilement réutilisables. L’objectif n’est plus seulement de convaincre un lecteur, mais de rendre chaque bloc compréhensible et exploitable dans le cadre d’un raisonnement automatisé.

- L’IA s’inscrit dans la continuité de l’EEAT : les agents s’appuient sur les signaux de crédibilité, de clarté et de spécialisation pour sélectionner les contenus utiles. L’expertise reste clé, mais elle doit être mise en évidence pour une machine qui n’a pas le temps de tout lire.

Comprendre le changement de paradigme

Le moteur classique : un index et une porte d’entrée

Le moteur de recherche tel que nous le connaissons depuis plus de vingt ans repose sur un schéma simple et efficace. L’utilisateur formule une requête, souvent brève, composée de quelques mots-clés. En retour, le moteur affiche une liste de résultats classés par pertinence supposée (les célèbres liens bleus de Google). Cette logique a façonné l’architecture du web et structuré le référencement naturel tel qu’on le pratique encore aujourd’hui.

Les requêtes sont souvent réduites à leur expression la plus concise (“meilleure mutuelle freelance”, “restaurant toulouse”). Le clic est central, chaque page visitée étant une tentative de réponse à la requête (et à l’intention de recherche) de l’utilisateur. Le suivi des performances est basé sur les positions, et le SEO repose en grande partie sur le ranking des pages et l’amélioration du CTR (taux de clic).

C’est un modèle efficace, mais linéaire, où l’humain reste seul maître du raisonnement et de la navigation.

Le moteur génératif : un assistant cognitif avant tout

À l’inverse, les moteurs dits “génératifs”, basés sur des modèles de langage comme GPT ou Gemini, adoptent une autre logique. Avec sa requête, l’utilisateur déclenche une réflexion. L’IA reformule, déduit, complète, interroge les sources.

La requête devient un prompt enrichi de nuances, d’objectifs implicites, et bien souvent ce procédé est influencé par un historique conversationnel. Les clics sont presque optionnels, ils sont relégués au second plan.

Dans ce contexte, la visibilité des acteurs devient plus difficile à mesurer, car chaque requête (mais aussi chaque réponse) est personnalisée et unique. Les liens vers les sites web servent de complément à une réponse “prémâchée”.

Le Chain of Thought : une révolution cognitive dans le Search

Le Chain of Thought, ou “chaîne de pensées”, marque une rupture majeure dans la façon dont les intelligences artificielles traitent les questions complexes. Introduit dans les publications scientifiques dès 2022, ce mécanisme de raisonnement n’a réellement pris de l’importance dans les modèles grand public qu’à partir de 2024, avec l’arrivée d’une nouvelle génération d’IA capables de structurer une réflexion logique sans assistance humaine. GPT-4 a été le premier modèle grand public à intégrer le CoT de manière implicite dans son fonctionnement.

Ce tournant technologique répond à une critique centrale formulée à l’égard des premiers modèles dits “génératifs”, popularisés par ChatGPT en 2023 (sur la base de GPT-3). Malgré leur aisance à produire du texte fluide, ces IA se contentaient de prédire le mot suivant sur la base de corrélations statistiques massives, sans comprendre ni structurer leurs réponses. Le résultat : des formulations convaincantes, mais souvent superficielles ou incohérentes.

Avec le Chain of Thought, cette logique probabiliste cède la place à un raisonnement explicite. L’IA décompose le prompt, formule des hypothèses, explore plusieurs pistes, et construit une réponse étape par étape, comme le ferait un expert humain.

Vous commencez à voir le potentiel pour la recherche web ?

Prenons un exemple concret

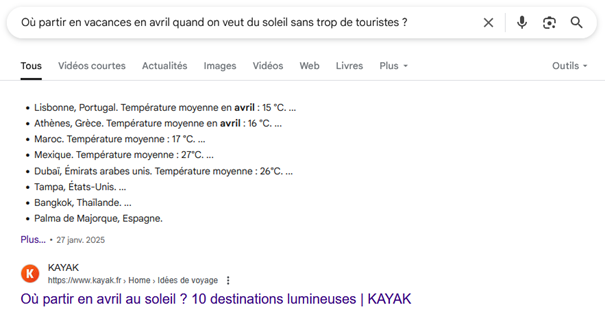

« Où partir en vacances en avril quand on veut du soleil sans trop de touristes ? »

Quand on lui pose cette question, un moteur de recherche classique comme Google va directement chercher des articles populaires sur les destinations en avril. Il est limité par l’existant, et privilégie donc les sites qui visent le plus juste, même si ils sont loin de répondre pleinement à l’intention de recherche.

Google est un peu dépassé sur le sujet (Bangkok et Dubaï sont respectivement les 6e et 2e villes les plus touristiques au monde…).

Un moteur basé sur le Chain of Thought a davantage de cordes à son arc. Il peut par exemple dans ce cas précis (si ses ressources le permettent) :

- Reformuler la requête de l’utilisateur pour affiner l’intention de recherche

- Identifier les destinations ensoleillées en avril, mais écarter celles qui sont réputées pour être très touristiques à cette période

- Prendre en compte le budget moyen et les moyens de transport disponibles

- Croiser les données météo avec les périodes d’affluence touristique

- Identifier les événements locaux (festivals, vacances scolaires) susceptibles d’augmenter la fréquentation

- Adapter ses suggestions selon le profil de l’utilisateur (nous reviendrons plus en détail sur ce point)

- Formuler une recommandation contextualisée et argumentée

- …et bien plus encore !

C’est là tout l’objet de la promesse de Google et de son « AI mode », déjà disponible aux Etats-Unis, et qui pourrait très bientôt débarquer sur les côtes européennes.

Des conséquences déjà visibles sur le SEO ?

Oui, et elles ne seront bientôt plus marginales. La transition vers des moteurs conversationnels capables de raisonner de façon indépendante risque de réorganiser en profondeur les dynamiques de visibilité sur le web. La vraie question qu’il faut se poser, c’est « combien de temps avons-nous pour nous y préparer ? »

L’introduction des résultats génératifs dans l’interface de Google révèle une tendance inquiétante : l’utilisateur clique moins. Ahrefs estime déjà la baisse du CTR à 34,5% en cas de présence d’un résumé IA en haut de la SERP. Si la vague n’est pas encore parvenue jusqu’à l’Europe, cela ne saurait tarder.

On peut tenter de se rassurer en se disant que c’est une tendance qui n’est pas vraiment nouvelle. Depuis quelques années, nous constatons comme beaucoup d’autres que l’écart se creuse irrémédiablement entre les impressions et les clics sur la Search Console de certains de nos projets.

Conséquence directe de l’apparition de nouveaux widgets sur les SERP (« position 0 » et autres « questions fréquentes », pour ne citer que les exemples les plus parlants).

Dans de nombreux cas, l’utilisateur n’a déjà plus besoin de consulter un site pour obtenir une réponse à sa question. Mais que se passera-t-il lorsque la réponse sera systématiquement synthétisée dans l’encart généré par l’IA en haut de la SERP ? Que se passera-t-il lorsque Google se mettra à trouver pour nous le bon produit ou service à acheter ? La tendance pourrait bien s’accélérer.

Un moteur de recherche à l’ère de l’IA générative, ça marche comment ?

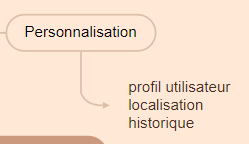

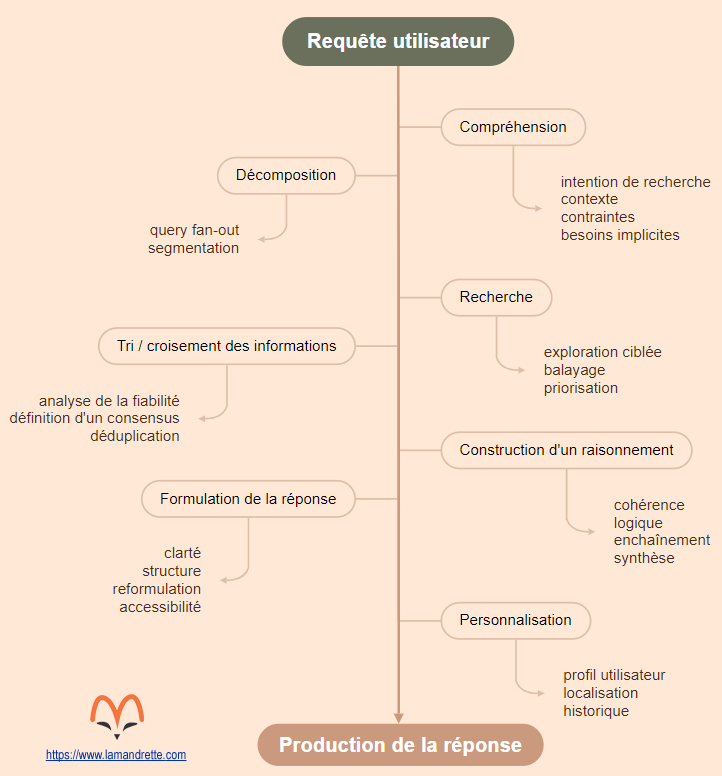

Depuis quelques mois, les experts sont nombreux à se pencher sur la question. Olivier de Segonzac est toujours à l’affut quand il s’agit de fouiller dans l’architecture interne des outils pour comprendre les facteurs de déclenchement de la recherche web (et ses différents niveaux de complexité). Si vous n’avez pas peur de l’anglais, nous vous recommandons également l’excellent article de Mike King sur le sujet.

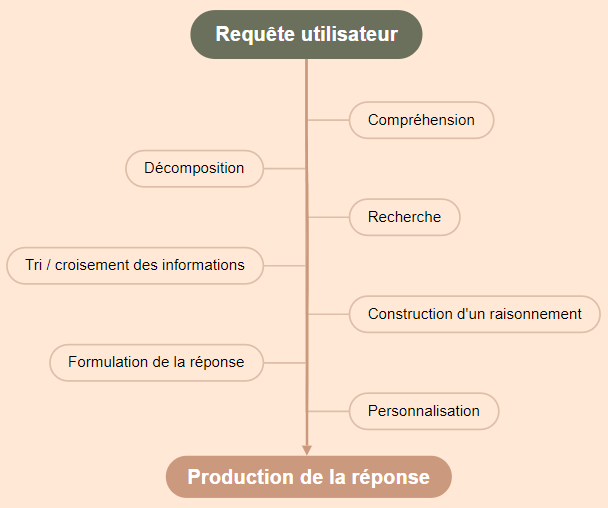

Comme eux, nous avons tenté de décomposer la logique qui se cache derrière ces moteurs de recherche d’un nouveau genre. Ce qu’il faut comprendre, c’est qu’il ne s’agit plus vraiment d’un moteur de recherche au sens classique du terme, mais d’un système de raisonnement automatisé, qui enchaîne les étapes comme le ferait un analyste : comprendre la question, poser d’autres questions en coulisses, chercher, croiser, trier, puis décider quoi vous dire.

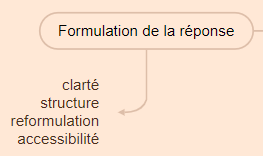

Ce fonctionnement théorique peut être décomposé en 7 grandes étapes (nous les avons ordonnées de 1 à 7, mais il est probable que le déroulé soit en réalité différent) :

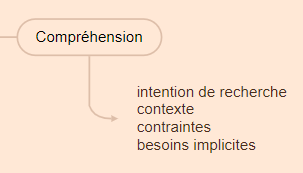

1 – Compréhension de la question

Le moteur produit une représentation sémantique dense de la requête, en identifiant l’intention principale, les objectifs implicites et les éventuelles contraintes contextuelles (lieu, moment, budget, profil utilisateur…).

Cette première étape pose le cadre du raisonnement : quelles dimensions du besoin explorer, dans quel ordre, et avec quel niveau de précision.

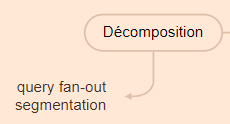

2 – Décomposition

La requête est éclatée en une série de sous-questions. C’est l’étape du « query fan-out », qui permet d’explorer finement chaque facette de l’intention de recherche. Chaque sous-requête devient un angle d’attaque autonome, qui sera traité, validé ou ignoré selon sa pertinence.

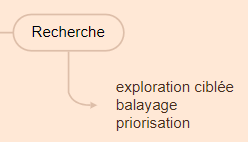

3 – Recherche orientée

Chaque sous-question générée peut déclencher des recherches ciblées.

Le moteur interroge des bases internes ou externes, en combinant recherche vectorielle (proximité sémantique) et RAG (Génération Augmentée de Récupération). Les résultats sont ensuite “échantillonnés” pour alimenter le raisonnement global.

L’IA explore plus ou moins profondément chaque source, collecte les éléments utiles, puis passe à la suivante. C’est un balayage rapide et stratégique.

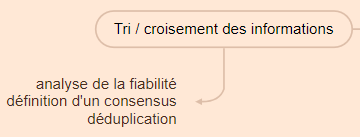

4 – Tri et croisement des informations

Les éléments récupérés sont scorés, comparés, réordonnés. L’agent trie les informations, évalue leur fiabilité, croise les points de vue et élimine les doublons. Il filtre pour ne garder que l’essentiel.

Ce processus de tri concerne aussi bien la forme que le fond, et il laisse de côté ce qui ralentit le raisonnement.

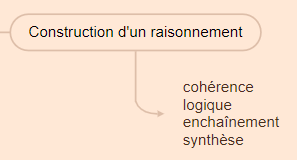

5 – Construction d’un raisonnement

Les informations validées sont organisées pour construire une réponse cohérente. L’IA structure ses idées, enchaîne les étapes déductives, hiérarchise les éléments retenus et trace un chemin explicite vers la conclusion.

C’est ici que le raisonnement prend forme, dans une dynamique d’enchaînement logique propre au Chain of Thought.

6 – Formulation d’une réponse claire

Le moteur rédige une réponse synthétique, reformulée pour être lisible, directe, et alignée avec l’intention initiale. Le style est épuré, les informations compactées, la hiérarchie précédemment établie est respectée.

7 – Personnalisation

La réponse est ajustée selon un profil utilisateur implicite : localisation, langue, historique, comportement conversationnel, type de terminal. Cette personnalisation silencieuse rend chaque réponse unique et difficile à reproduire, ce qui complexifie radicalement toute tentative de suivi ou d’optimisation SEO traditionnelle.

SEO : comment s’adapter face à un moteur qui pense à notre place ?

Si l’essor des moteurs génératifs ne signe pas la fin de notre métier, nous restons convaincus qu’il va en modifier les règles fondamentales. Et si, bientôt, le SEO ne consistait plus à se battre pour des positions ? Et s’il était temps pour nous d’apprendre à influencer un raisonnement ?

Comprendre ce que cette mutation va changer pour le SEO

Les clics et les positions ne sont plus des objectifs absolus

Nous l’avons vu plus haut, la chute du CTR est déjà documentée (et ce n’est que le début). L’objectif affiché de ces nouveaux moteurs de recherche est de servir les informations sur un plateau d’argent à l’utilisateur.

Votre site web risque de devenir progressivement un fournisseur silencieux de réponses, plutôt qu’un lieu d’interaction directe. De là à dire que les modèles de mesure basés sur les positions et les clics vont devenir structurellement obsolètes ? Semrush, Ahrefs, Haloscan peuvent trembler… ou s’adapter eux aussi à cette nouvelle tendance.

Le comportement des IA diffère grandement des moteurs de recherche classiques

Pour comprendre la singularité de cette nouvelle tendance, il faut se tourner vers les entreprises qui sont parvenues à récupérer des données à grande échelle. L’étude menée par Profound sur le comportement de ces agents nous fournit déjà plusieurs enseignements… mais aussi quelques résultats contre-intuitifs :

- 95 % du comportement de citation des IA n’est pas corrélé au trafic des sites web. Les agents privilégient le contenu qui facilite la construction d’une réponse, avec une logique de consensus.

- A ce jour, les backlinks sont presque insignifiants dans les logiques de sélection des IA.

- Le contenu interactif ou dynamique (JS, carrousels, visuels complexes) est largement ignoré.

Ces comportements peuvent être partiellement expliqués par les limites actuelles de ces agents. Ce qu’il faut comprendre, c’est que ces modèles sont opportunistes et paresseux : ils ne lisent pas les pages dans leur intégralité, ils privilégient les sites clairs, structurés, faciles à exploiter immédiatement.

Toujours dans cette même étude, l’entreprise observe donc logiquement que les signaux suivants sont positivement corrélés à l’usage :

- La présence de données structurées (Schema.org, tableaux, balisage HTML clair)

- Les métadonnées bien remplies (title, description, Hn)

- …même les URL explicites semblent jouer en faveur des pages citées !

Faut-il donc prendre au sérieux cette nouvelle tendance du fichier LLMS.txt, destiné à guider les agents LLM (à la manière d’un robots.txt, mais pour le raisonnement) ?

L’utilisateur “lambda” n’existe plus

Et si, dans ce nouveau modèle, la notion d’utilisateur moyen devenait caduque ?

Si l’on part du principe que les résultats affichés par un LLM varient selon un « profil implicite », deux utilisateurs posant une question identique peuvent recevoir des réponses totalement différentes.

Cela rend le suivi de performance sur mots-clés génériques moins fiable, et le suivi de position en mode “déconnecté” (incognito, sans historique) presque vide de sens. Oui, oui, nous vous parlons bien de la fameuse recherche en navigation privée pour vérifier que votre site est toujours dans le top 3 sur la grosse requête ciblée. Même les habitudes les plus ancrées pourraient être remises en question.

La logique sémantique devient structurelle

Faute de temps et de ressources, les agents cherchent des briques de sens facilement assemblables. Et ce raisonnement ne suit pas le parcours linéaire d’un utilisateur : il découpe, croise, priorise, et ignore tout ce qui le ralentit.

Autrement dit :

- Les contenus non segmentés sont inutilisables.

- Les pages qui ciblent des requêtes trop larges sans logique de persona risquent d’être déclassées dans la chaîne de raisonnement.

- Les pages qui répondent à des sous-questions implicites, ou qui annoncent clairement pour qui le produit ou le service est pensé, peuvent théoriquement acquérir un avantage stratégique sur la concurrence.

7 nouveaux réflexes à adopter dans la production et l’organisation du contenu

Loin d’un effondrement, le SEO devrait changer progressivement de nature. Moins fondé sur le clic, davantage orienté vers la valeur fonctionnelle du contenu, il devrait plus que jamais se concentrer sur la valeur réelle des produits et services que vous proposez.

Nous vous proposons 7 premiers réflexes à implémenter dans vos stratégies sur le long terme, pour aborder cette transition en douceur.

1 – Écrivez pour les agents, pas pour les crawlers

Les LLMs n’ont pas besoin d’introductions engageantes ni de storytelling. Ils fouillent, trouvent, simplifient, synthétisent. Un bon contenu, à leurs yeux, est un contenu structuré, direct et segmenté correctement.

- Commencez par la réponse, pas par le contexte. Si vous mettez l’essentiel en bas de page ou de paragraphe, vous serez ignoré.

- Créez des blocs à forte densité informationnelle : tableaux, listes comparatives, résumés opérationnels…

- Adoptez une logique de “contenu prêt à extraire” : ce que vous écrivez doit pouvoir être collé tel quel dans une réponse IA. Car c’est ce que les agents font (littéralement) lorsqu’ils récupèrent votre contenu pour l’analyser.

2 – Pensez en personas plutôt qu’en audience globale

Les moteurs génératifs produisent une réponse pour un utilisateur donné, dans un contexte donné. Ce fonctionnement impose un changement de posture : vous ne rédigez pas pour un public neutre, mais pour des personas implicites que l’IA projette sur les utilisateurs.

- Prévoyez vos segments à partir de vos cibles : débutant, pressé, comparateur, local, technicien, etc.

- Rendez ces cibles visibles dans le contenu : via des pages dédiées, des encarts, des formulations explicites, des sous-titres comme :

“Idéal pour les auto-entrepreneurs”

“Pour les équipes RH de moins de 50 salariés”

“Le bon choix si vous hésitez entre deux solutions”

Ces signaux aident l’agent à relier le contenu au profil de son utilisateur. C’est une forme d’alignement sémantique, mais orientée usage.

3 – Travaillez les sous-questions et les intentions de recherche implicites

Chaque requête posée à un agent entraîne des sous-questions implicites. Ce sont elles qui pilotent le raisonnement. Le problème, c’est qu’elles ne sont jamais visibles, (à moins d’analyser finement les tendances).

- Créez des pages qui anticipent les objections et les angles secondaires.

- Repérez les sous-requêtes potentielles : en scrutant les « People Also Ask », les réponses de Perplexity, ou les posts dans les forums.

- Structurez vos contenus comme des arbres décisionnels. Pas pour faire joli, mais pour alimenter un raisonnement algorithmique qui va chercher des morceaux de réponse là où il les trouve.

- Exploitez l’IA générative pour la prendre à son propre jeu et anticiper ses comportements (cf. cas pratique ci-dessous).

4 – Repensez votre vision de la performance

Le positionnement brut, mesuré en navigation privée, pourrait se déconnecter progressivement de la réalité de votre cible.

- Testez des scénarios utilisateurs : profils localisés, intentions de recherche variées, formulations divergentes.

- Acceptez la granularité : vous ne “rankez” plus globalement, mais par fragment, dans un contexte précis. Et ça change totalement le sens des métriques classiques.

- Repensez votre monitoring : en attendant que les outils SEO s’adaptent, privilégiez les études user-centric pour comprendre votre cible et les comportements dans des environnements personnalisés.

5 – N’ayez pas peur des pages à faible trafic

À l’origine, le terme de « pages zombies » visait des pages peu utiles, peu visitées, avec un contenu trop pauvre, parfois générées par des systèmes de filtre ou de pagination. Aujourd’hui, beaucoup utilisent ce terme pour englober toutes les pages à faible trafic. Cette vision réductrice passe à côté d’une vérité structurelle : une page peut être stratégiquement silencieuse, mais sémantiquement précieuse.

Si la page apporte de la valeur ajoutée à votre site, c’est l’essentiel !

6 – Optimisez pour une machine paresseuse

Les agents lisent vite, survolent, interprètent à la volée. Ils se concentrent sur les zones à forte valeur sémantique. En priorité, ils scannent l’URL, les balises title et meta description, les H1, H2, H3, le haut de page… les paragraphes ne sont survolés que si la page, puis la section correspondante sont jugées pertinentes. Un contenu dense mais flou ne sera pas lu. Un contenu clair, structuré, balisé, pertinent, oui.

- Mettez en place tous les marqueurs exploitables : balises Hn, Schema.org, données structurées FAQ, encarts produit…

- Expérimentez avec les fichiers LLMS.txt, en anticipant un futur proche où l’on guidera explicitement les IA comme on guide le crawl des robots d’exploration

- Soignez l’architecture HTML : un code propre, une structure logique, une hiérarchie nette = un contenu exploitable.

7 – Prouvez votre expertise

Dans la continuité de l’EEAT, les agents LLM valorisent les contenus crédibles, sourcés et contextualisés. Pour qu’un raisonnement automatisé puisse s’appuyer sur vos pages, vous devez rendre visibles vos signaux de confiance.

- Citez vos sources, auteurs et références (avec liens sortants) : il peut même être intéressant de prévoir des sections dédiées

- Affichez les dates de publication et de mise à jour

- Identifiez clairement les experts : nom, fonction, légitimité à traiter le sujet

8 – Restez humain

Ce qui fait la différence, c’est votre expertise, votre regard, votre capacité à éclairer un sujet avec nuance. Ne perdez pas de vue l’essentiel : vous écrivez pour être compris, pas seulement pour être réutilisé. La valeur naît de la clarté, de la précision, mais aussi de l’intention que vous mettez dans chaque mot.

Garder le contrôle dans un écosystème SEO piloté par l’IA

Le SEO est entré dans une phase de transition, et les changements à venir sont déjà visibles pour qui les observe attentivement. Moins de clics, des réponses servies sur un plateau sur les SERP, des données plus difficiles à récupérer…

Non, ce n’est pas la fin du SEO, mais c’est un point de bascule. Et ceux qui sauront s’adapter auront une longueur d’avance. Pas besoin de tout réinventer : dans la continuité de l’EEAT, la recherche générative nous invite à produire mieux, plus lisible, plus ciblé, en recentrant nos efforts sur notre réelle valeur ajoutée.

Mais il faut aussi garder les pieds sur terre, le spam n’a pas dit son dernier mot. Cette transition ouvre la porte à une explosion de contenus calibrés pour l’IA, souvent au détriment de la qualité réelle. Le rôle des consultants SEO sera d’apporter du discernement face à ces nouveaux paradigmes.

L’intelligence artificielle transforme notre métier à toute vitesse ! Pour rester informé :

L’auteur : Titulaire d’un master en communication, Fantin a occupé plusieurs postes (rédacteur SEO, chargé de projet) avant de devenir consultant. En poste chez La Mandrette depuis 2021, il met en œuvre les actions SEO sur les projets clients.