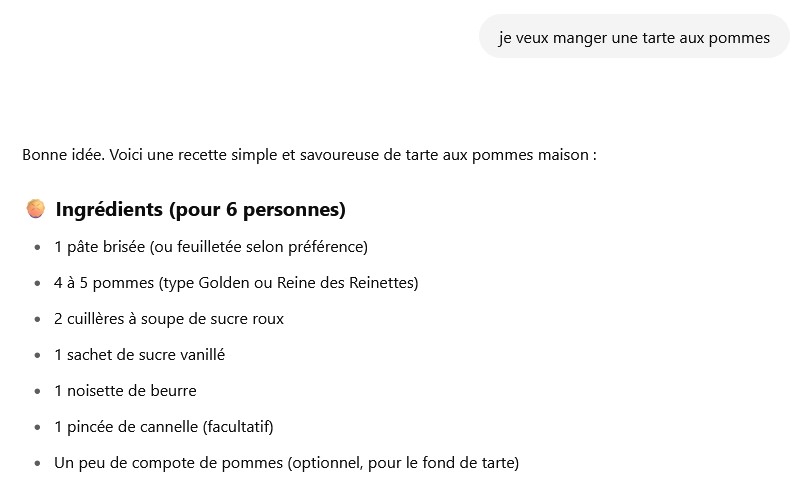

Face à un modèle de langage, il y a plusieurs façons de formuler un prompt. Le zero-shot prompting, souvent utilisé par défaut, consiste à formuler une demande sans ajouter d’exemple.

Définition technique

Le zero-shot prompting implique de formuler une consigne directe dans un prompt, afin qu’un modèle réalise une tâche sans avoir vu d’exemple similaire auparavant.

C’est la forme la plus simple d’interaction avec un modèle de langage : l’utilisateur lui donne une consigne, il répond. Sans exemple, cette approche repose uniquement sur la clarté du prompt et les capacités générales du modèle. Elle permet de tester rapidement la réalisation d’une tâche ou de générer une réponse directe, mais reste limitée pour les cas complexes ou ambigus.

Les avantages du zéro-shot prompting

Il est relativement simple à mettre en œuvre : il suffit de formuler une consigne claire, sans fournir d’exemple. Cela le rend particulièrement adapté pour tester un modèle sur une nouvelle tâche, sans phase de préparation.

Un modèle de langage généraliste, comme GPT ou Gemini, est entraîné au préalable sur une grande base de données. Cela lui permet souvent de comprendre ce qu’on attend de lui même sans exemple, à condition que la consigne soit bien formulée. Le zero-shot fonctionne donc très bien pour des tâches courantes ou générales : résumer un texte, répondre à une question concrète, effectuer une recherche en ligne…

Cette méthode est également plus économe en ressources.

Les limites de cette méthode

Le principal inconvénient du zero-shot est le manque de contexte : sans exemple, le modèle peut interpréter la tâche à accomplir de manière approximative ou incorrecte.

Par ailleurs dès que la complexité des problèmes à résoudre augmente, les performances sont généralement moins fiables que celles obtenues avec du few-shot prompting, où des exemples explicites guident la tâche. Pour des tâches plus spécialisées, le modèle peut produire des réponses génériques ou erronées, faute de cadre clair.

Notons aussi que la qualité du rendu dépend fortement de la qualité de la formulation du prompt : une mauvaise consigne entraîne souvent un échec.

Quelles sont les méthodes alternatives ?

Le zero-shot prompting n’est pas une “méthode à part entière”. C’est une des nombreuses formes d’interaction possibles avec un modèle de langage pré-entraîné. Pour bien comprendre où elle se situe, il faut distinguer deux grands axes dans les manières d’utiliser un LLM : ce qu’on fait du modèle et comment on lui parle.

1. Ce qu’on fait du modèle (niveau d’adaptation)

- Modèle inchangé : on utilise le modèle tel quel, avec un simple prompt.

- Modèle adapté : on modifie le modèle pour une tâche précise. Cela passe par du fine-tuning, de l’instruction tuning, ou des méthodes plus légères comme LoRA (Low-Rank Adaptation).

2. Comment on lui parle (niveau d’instruction)

La liste des stratégies est longues, mais on peut notamment citer :

- Zero-shot : une consigne directe, sans exemple.

- Few-shot : consigne + quelques exemples pour guider le comportement.

- Chain-of-thought : la consigne encourage un raisonnement étape par étape.

- RAG (Retrieval-Augmented Generation) : on fournit des données externes (documents, contexte enrichi) sans changer le modèle.

- Utilisation d’outils et d’API : on combine le modèle avec des outils pour l’aider à produire une réponse (calculatrice, base de données…).

Ces méthodes évoluent rapidement, et de nouvelles approches apparaissent régulièrement à mesure que la recherche progresse sur l’exploitation fine des modèles de langage. Dans ce contexte, le zero-shot ne représente que la forme la plus élémentaire d’interaction avec un modèle de langage.

Retrouvez les meilleures définitions dans le glossaire SEO de La Mandrette !

L’auteur : Titulaire d’un master en communication, Fantin Deliège a occupé plusieurs postes (rédacteur, chargé de projet) avant de devenir consultant à La Mandrette. Depuis 2021, il met en œuvre les actions SEO sur les projets clients.

- Le Chain of Thought, chaîne de pensée des IA

- Le Zero-shot prompting, pour les utilisateurs (trop !) pressés